O uso de modelos de inteligência artificial (ML/LLM) em produtos e processos traz riscos novos e específicos: a superfície de ataque inclui não só APIs e infra, mas também prompts, datasets, pipelines de treino e o próprio comportamento gerado pelo modelo.

No Pentest em IA, nós avaliamos essa superfície com técnicas ofensivas que vão desde tentativas de prompt injection e jailbreak até ataques à cadeia de fornecimento e envenenamento de dados.

Neste artigo, você irá entender o que é o Pentest em IA, quais são as ameaças mais frequentes e como funciona um teste.

O que é Pentest em IA?

Pentest em IA se refere a testes que aplicam técnicas ofensivas em sistemas que usam modelos de machine learning (incluindo LLMs) para identificar riscos específicos.

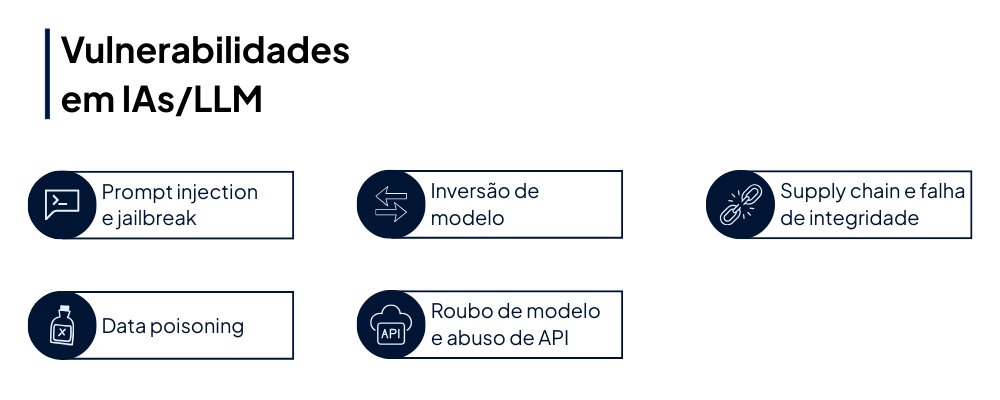

Alguns dos mais frequentes são: prompt injection, jailbreak, envenenamento/poisoning de dados, extração de informação sensível (inversão de modelo), roubo de modelo por API e compromissos na cadeia de fornecimento (builds, weights, dependências).

Diferentemente de um pentest tradicional, o pentest em IA testa também comportamento probabilístico do modelo, integridade dos dados de treino, pipelines de MLOps e mecanismos de contenção/filtragem.

O que é testado em um Pentest de IA?

Esse tipo de teste busca por diferentes tipos de ameaças, como:

- Prompt injection & jailbreak: manipulação de instruções ou contexto para induzir o modelo a revelar informações sensíveis ou executar comportamentos proibidos.

- Data poisoning / training-time attacks: adulterar dados de treino para enviesar o modelo ou introduzir backdoors.

- Inversão de modelo e membership inference: extrair informações sensíveis sobre dados de treino a partir das respostas do modelo.

- Roubo de modelo e abuso de API: roubo de propriedade intelectual via queries e reconstrução do modelo ou seus parâmetros.

- Supply chain e falhas de integridade: comprometimento de dependências, artefatos de build, repositórios e pipelines que permitem inserir código ou weights maliciosos.

- Entre outros.

Modelos de Inteligência Artificial possuem suas particularidades, portanto, é preciso que o Pentest seja conduzido especificamente para esse tipo de ativo, e por profissionais qualificados para lidar com essas ameaças.

Frameworks para Pentest em IA

Para que os pentests em IA agreguem valor, sejam auditáveis e tragam o melhor resultado possível, eles devem ser alinhados a frameworks reconhecidos pelo mercado. Os principais deles são:

- AI Risk Management Framework, da NIST

- ATLAS, da MITRE (complementar ao MITRE ATT&CK)

- OWASP Top 10 de LLM e Apps Gen AI

Como proteger suas IAs/LLM

O pentest traz recomendações personalizadas conforme as vulnerabilidades encontradas e as particularidades do modelo. Porém, existem algumas medidas que frequentemente se repetem:

- Hardening de prompts e pipelines: escape handling, prompt sanitation, e context minimization.

- Proteção de datasets: controle de acesso, validação de origem, e monitoração de anomalias de input.

- Assinatura e verificação de artefatos: proteger weights e builds com assinatura digital e verificação no deploy.

- Rate limiting e análise de padrão de queries: detectar scraping, tentativa de extração ou abuso de API.

- Monitoramento e alertas baseados em comportamento: logs estruturados de queries e respostas, integrações com SIEM/SOAR.

Quer conhecer o Pentest em IA da Vantico? Clique aqui e fale conosco.

Siga a Vantico nas redes sociais e fique informado sobre cibersegurança, tecnologia e insights.

FAQ: Perguntas frequentes sobre Pentest em IA

1. Com que frequência devo fazer pentest em IA?

Pelo menos uma vez a cada lançamento significativo do modelo. Ou, como regral geral, pelo menos uma vez ao ano.

Ambientes com deploy contínuo e uso intensivo de LLMs exigem ciclos mais curtos e testes que se encaixem nessa frequência.

2. É seguro testar modelos em produção?

O ideal é que os testes sejam executados em ambientes controlados. Porém, caso seja necessário testar em produção, é importante estabelecer regras rígidas.

3. Como o Pentest em IA se diferencia do pentest tradicional?

Além de verificar infra, APIs e aplicações, o pentest em IA testa comportamento probabilístico do modelo e vetores específicos, como manipulação do prompt, envenenamento de dados, extração de informações do modelo, etc.

Além disso, inclui análise de dados, revisão de pipelines e testes de comportamento (jailbreak/adversarial), não apenas exploração de vulnerabilidades clássicas.

4. Quais são os principais vetores de ataque em sistemas de IA?

Alguns dos principais são prompt injection/jailbreak, data poisoning, inversão do modelo/membership inference, roubo de modelo/abuso de APIs, supply chain e falhas de integridade, entre outros.

5. Como é feito o escopo de um pentest em IA?

O escopo é definido durante o kick-off: inventário de modelos e versões, endpoints públicos/privados, datasets e localização (on-prem/cloud), pipelines CI/CD, integrações com terceiros (APIs de LLM), requisitos regulatórios e limites operacionais