A Inteligência Artificial (IA) está transformando a forma como empresas detectam, analisam e respondem a ameaças cibernéticas.

Com a complexidade dos ataques e a velocidade com que eles ocorrem, os sistemas tradicionais de segurança têm dificuldades para acompanhar.

Nesse cenário, a IA se destaca, oferecendo capacidade de processar grandes volumes de dados, identificar padrões anômalos e gerar alertas quase em tempo real.

A Inteligência Artificial Generativa, em especial, vem ganhando destaque por sua capacidade de sintetizar informações complexas e apresentar análises em linguagem natural.

Ferramentas estão sendo desenvolvidas a fim de apoiar analistas de segurança na investigação de incidentes, geração de relatórios e resposta a ameaças de forma mais ágil e precisa.

No entanto, mesmo com todo esse potencial, a IA não é infalível — e também precisa ser testada e protegida, por meio do Pentest em Inteligência Artificial.

Pentest em Inteligência Artificial

O avanço da Inteligência Artificial, especialmente com a popularização dos modelos de linguagem (LLMs), trouxe inúmeros benefícios, mas também abriu novas frentes de risco para a segurança cibernética.

Os pentests são essenciais para identificar falhas de segurança em qualquer tecnologia, e no contexto da IA, isso se torna ainda mais crítico.

Aplicações baseadas em IA normalmente são construídas sobre linguagens de programação populares, como Python e JavaScript, o que as torna vulneráveis aos mesmos ataques que ameaçam sistemas tradicionais.

No entanto, os LLMs trazem uma camada extra de complexidade: eles interagem com linguagem natural, tomam decisões autônomas com base em grandes volumes de dados e são capazes de executar ações fora do escopo originalmente previsto.

Por isso, realizar pentests em sistemas de Inteligência Artificial não se resume apenas a escanear portas ou verificar injeções de SQL. É necessário testar como a IA responde a inputs maliciosos, se comporta sob pressão de carga, ou se expõe dados sensíveis inadvertidamente.

Ferramentas tradicionais precisam ser adaptadas, e novas técnicas específicas para ambientes de IA têm sido desenvolvidas.

Os desafios do Pentest em Inteligência Artificial

Realizar pentests em sistemas baseados em Inteligência Artificial representa uma nova fronteira para os profissionais de segurança. Embora a IA ofereça avanços significativos na detecção e resposta a ameaças, ela também apresenta complexidades que desafiam as abordagens tradicionais.

Diferente de aplicações tradicionais, sistemas de IA, especialmente LLMs, tomam decisões com base em entradas altamente variáveis e treinamentos realizados com grandes volumes de dados.

Isso exige que o especialista entenda não apenas as falhas técnicas, mas também o comportamento do modelo diante de diferentes cenários e interações humanas.

Outro grande desafio é que, por mais poderosa que seja, a Inteligência Artificial não resolve todos os problemas de segurança. Atacantes continuam evoluindo suas táticas para explorar novas tecnologias, e isso inclui o uso da própria IA como arma.

Ferramentas automatizadas são úteis para detectar falhas conhecidas, mas não substituem a inteligência humana e o olhar crítico de especialistas em segurança.

Por isso, os pentests em IA precisam ir além da superfície: devem simular ataques criativos, abusar da lógica do modelo e explorar potenciais falhas emergentes – como injeções de prompt, manipulação de saída e exposição de dados sensíveis.

Quando combinados com estratégias de red teaming, esses testes revelam não só se um sistema está protegido contra ameaças já conhecidas, mas também o quão resiliente ele é frente a ataques não convencionais.

Como as vulnerabilidades se manifestam em um ambiente de IA

Aplicações de Inteligência Artificial apresentam uma combinação de vulnerabilidades já conhecidas com riscos inéditos, específicos da forma como os modelos interagem com o ambiente e os usuários.

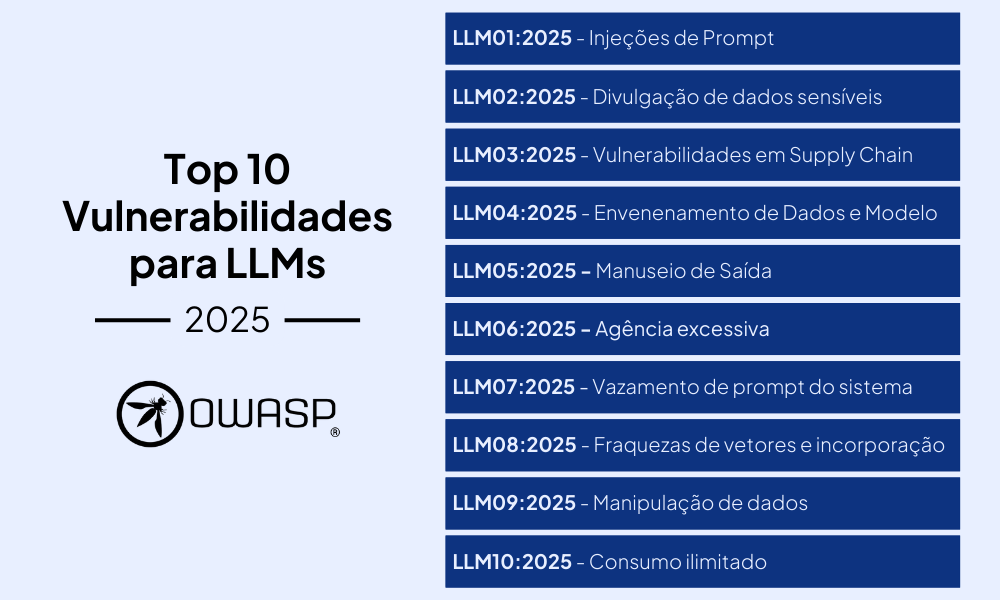

O projeto OWASP Top 10 for LLMs foi criado justamente para ajudar a entender e mitigar esses riscos. Ele categoriza as falhas mais críticas em sistemas baseados em modelos de linguagem de grande escala.

Injeções de Prompt: são quando entradas (prompts) de usuários alteram o comportamento ou a resposta do modelo de forma não intencional. Isso pode acontecer mesmo que o conteúdo malicioso não seja visível aos humanos, podendo gerar vazamento de dados sensíveis e quebra de outros protocolos.

Divulgação de dados sensíveis: modelos criados por IA podem, mesmo que não intencionalmente, expor dados sensíveis da empresa. Essas exposições podem acontecer tanto nos próprios modelos quanto nos aplicativos que os utilizam, levando a violações de privacidade, vazamento de propriedade intelectual e acesso não autorizado.

Vulnerabilidades de Supply Chain: falando sobre LLMs a supply chain pode ser comprometida em várias etapas, desde o uso de modelos pré-treinados e dados de terceiros até a implantação em dispositivos e plataformas na nuvem, causando quebras de segurança falhas de sistemas além de outras vulnerabilidades que se adequam conforme o tipo de modelo de LLM ou supply chain.

Envenenamento de Dados e Modelo: o efeito dessa vulnerabilidade segue à risca o significado do nome. A contaminação de dados ocorre quando dados usados em diversas etapas do LLM são manipulados para introduzir vulnerabilidades, backdoors ou vieses. Isso pode comprometer a segurança, o desempenho e a ética do modelo, resultando em saídas prejudiciais ou capacidades prejudicadas.

Manuseio de Saída: o manuseio inadequado de saídas refere-se à validação insuficiente e o tratamento inadequado das saídas geradas por modelos de linguagem grande (LLMs) antes de serem enviadas para outros sistemas e componentes. A exploração bem-sucedida de uma vulnerabilidade de manuseio inadequado de saídas pode resultar em ataques como XSS, CSRF, SSRF, elevação de privilégios ou execução remota de código em sistemas backend.

Agência excessiva: o termo refere-se à vulnerabilidade que permite que ações prejudiciais sejam executadas em resposta a saídas inesperadas, ambiguidades ou manipulações no comportamento de um modelo de linguagem grande (LLM). Essa vulnerabilidade ocorre quando o LLM tem um excesso de funcionalidades ou permissões, ou seja, capacidade de interagir com sistemas externos, como extensões (ferramentas, plugins, etc.), sem uma supervisão adequada. Com isso, o sistema pode executar ações indesejadas, mesmo que as falhas sejam causadas por uma entrada inadequada ou maliciosa.

Vazamento de prompt do sistema: a vulnerabilidade de vazamento de prompt do sistema ocorre quando informações sensíveis são inadvertidamente incluídas nos prompts ou instruções usadas para orientar o comportamento do modelo, o que pode ser explorado por atacantes para facilitar outros tipos de ataques. O risco não está no vazamento do prompt em si, mas na armazenagem inadequada de dados confidenciais (como credenciais e strings de conexão) ou na delegação inadequada de controles de segurança para o LLM, comprometendo a confidencialidade e a integridade do sistema.

Fraquezas de vetores e incorporação: essa vulnerabilidade está associada ao uso de Retrieval Augmented Generation (RAG) em modelos de linguagem, que podem ser exploradas por ações maliciosas para injetar conteúdo prejudicial, manipular saídas do modelo ou acessar informações sensíveis. os riscos incluem acesso não autorizado a dados, vazamento de informações, ataques de inversão de embeddings e mais.

Manipulação de dados: conhecida como Misinformation, essa vulnerabilidade aborda modelos de linguagem (LLMs) para gerar informações falsas ou enganosas que parecem confiáveis, podendo causar danos legais, de reputação e de segurança. Outros fatores incluem viés nos dados, códigos alterados e informações incompletas, agravados pela confiança excessiva dos usuários sem verificação.

Consumo ilimitado: aqui, a vulnerabilidade está em aplicações baseadas em LLMs que permitem uso excessivo e descontrolado de recursos computacionais, causando riscos como negação de serviço (DoS), prejuízo financeiro , roubo de modelo, e degradação do serviço. Isso ocorre quando usuários ou atacantes exploram a inferência do modelo com entradas extensas, consultas complexas ou volume elevado de requisições.

A IA é a resposta para os problemas de cibersegurança?

A resposta curta é: não de modo definitivo ou completo. A IA precisa ser vista como uma aliada poderosa e não uma solução única para todos os desafios da cibersegurança.Por um lado, a IA amplia a capacidade de defesa ao identificar ameaças com mais rapidez e eficiência.

Mas, por outro lado, ela também pode ser explorada por atacantes. Tecnologias como IA Gen têm sido usadas para criar ataques mais convincentes, automatizar scripts maliciosos e burlar sistemas tradicionais.

Além disso, a IA depende de dados de treinamento. Se esses dados forem manipulados ou incompletos, o modelo pode apresentar vieses ou falhas críticas. Outro ponto preocupante é a explicabilidade: entender por que uma IA tomou determinada decisão nem sempre é simples e isso pode ser um risco.

Ataques simples ainda podem enganar sistemas de Inteligência Artificial. Casos já documentados mostram como pequenos ajustes em imagens ou textos podem confundir completamente um modelo, resultando em comportamentos perigosos ou inesperados.

A Inteligência Artificial está redefinindo o cenário da cibersegurança, tanto para bem quanto para mal. O uso de IA na defesa digital pode acelerar a detecção e resposta a ameaças, mas também cria novos vetores de ataque que precisam ser rigorosamente testados.

Realizar pentests específicos em aplicações de IA é uma prática essencial para garantir que esses sistemas estejam realmente protegidos. A segurança, afinal, não deve ser um estado, mas um processo contínuo de avaliação, adaptação e melhoria.

Aliar pentests, Inteligência Artificial e outras ferramentas é criar uma estratégia robusta e eficaz de segurança cibernética.

A Vantico tem diversas modalidades e ferramentas disponíveis para sua empresa. Clique aqui e encontre a que mais se adequa ao seu modelo de negócio.

Siga a Vantico nas redes sociais para acompanhar as principais novidades sobre cibersegurança.