Você já ouviu falar em LLM? Esse é o modelo de aprendizado utilizado por grande parte das ferramentas de Inteligência Artificial, e são capazes de analisar e gerar textos complexos em linguagem humana.

Neste artigo, você irá entender o que é LLM, quais são os riscos associados a ele, o que é o Pentest LLM e as principais práticas recomendadas.

O que é LLM?

A sigla LLM significa “Large Language Model” (Modelo de Linguagem Ampla, em português), e representa modelos de aprendizado de máquina (machine learning) que compreendem e geram textos em linguagem humana.

Esse tipo de modelo de aprendizagem tem a capacidade de analisar grandes conjuntos de dados, sendo utilizado por grande parte das Inteligências Artificiais (IAs). Um dos exemplos mais famosos é o Chat GPT.

Pelo aumento da quantidade de ferramentas que utilizam esse modelo de aprendizado, assim como pelo crescimento da relevância das Inteligências Artificiais, aplicações que usam LLM têm se tornado um grande alvo dos criminosos cibernéticos.

Riscos envolvendo LLM

Existem vários riscos envolvendo esse modelo de aprendizado, que podem ser explorados por criminosos de diversas maneiras. Alguns deles são:

- Vazamento de dados

Os modelos de linguagem analisam grandes conjuntos de dados em seu treinamento, incluindo informações sensíveis. Sem políticas de segurança e privacidade, esses dados podem aparecer nas respostas geradas, ocasionando uma exposição não-autorizada.

- Ataques de manipulação de modelo

Alguns ataques são executados com o objetivo de manipular o comportamento da aplicação, fazendo com que ela gere respostas específicas.

Podem acontecer ataques chamados de envenenamento de dados, durante o treinamento do modelo, ou ataques de manipulação de entrada, o que induz respostas indesejadas.

- Geração de conteúdo malicioso

Por sua alta capacidade de analisar dados e gerar respostas complexas, os LLMs também são muito utilizados por criminosos para gerar spam, criar conteúdos maliciosos, phishing, e outros tipos de ataques.

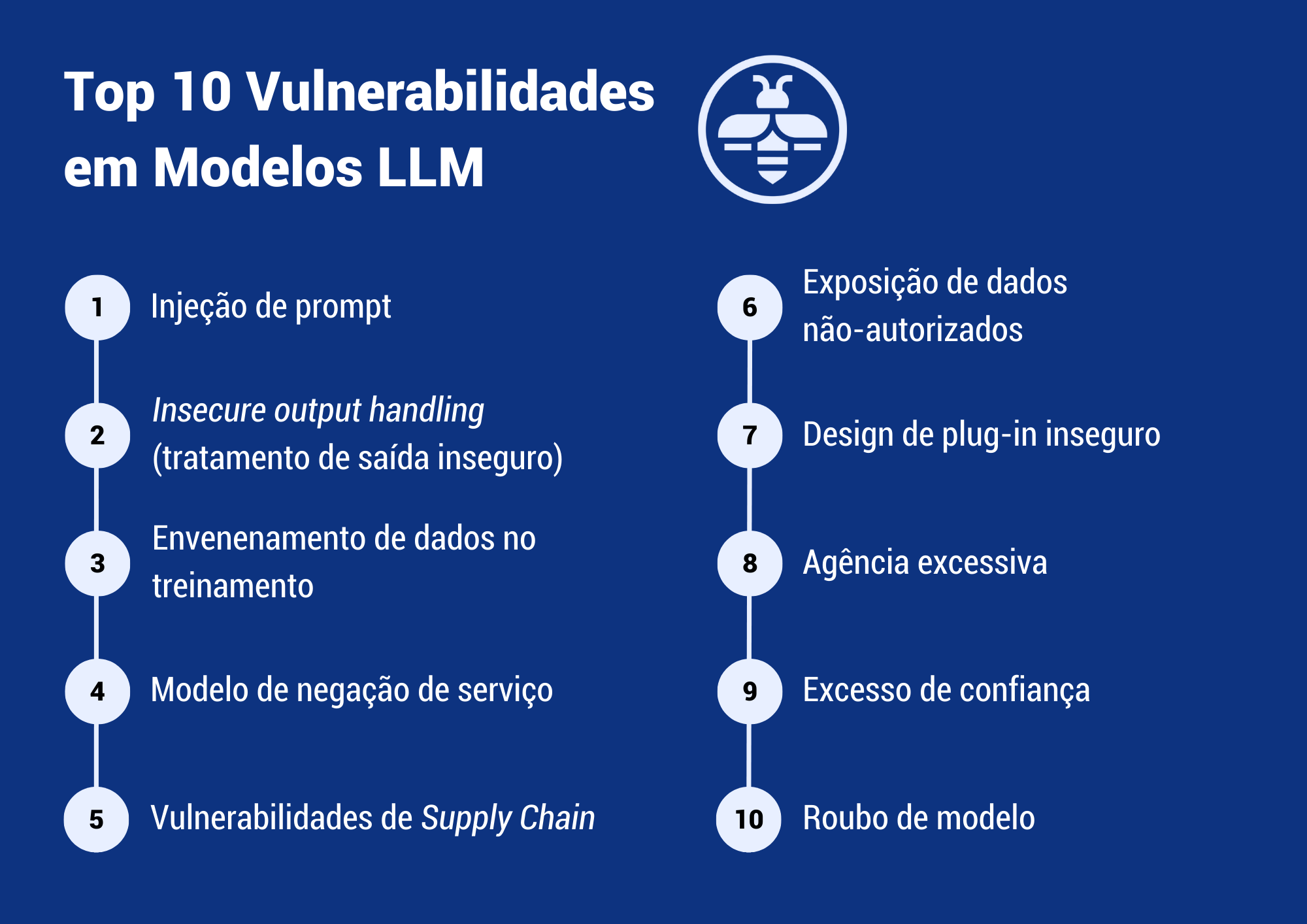

OWASP Top 10 Vulnerabilidades em Modelos LLM

A OWASP, um dos principais órgãos internacionais de segurança cibernética, também apresenta as 10 principais vulnerabilidades que afetam esse tipo de aplicação:

Pentest LLM

O Pentest LLM representa a aplicação do Pentest em ativos que utilizam LLM, com o objetivo de eliminar possíveis essas e outras vulnerabilidades e evitar ciberataques. Ele pode incluir:

- Identificação de vetores de ataques;

- Análise de entradas maliciosas que podem tentar enganar o sistema;

- Testes de injeção de código;

- Análise de falhas na arquitetura;

- E vários outros pontos.

O Pentest é uma das medidas essenciais para garantir a segurança de aplicações que utilizam o LLM, principalmente por essa ser uma área ainda em desenvolvimento.

Práticas para o Pentest LLM recomendadas pela OWASP

A OWASP ainda traz um checklist com as melhores práticas para melhorar a precisão e a segurança de modelos LLM, que envolvem:

- Risco adversário;

- Modelagem de ameaças (Threat Modeling);

- Inventário de ativos de IA;

- Treinamento em segurança e privacidade de IA;

- Estabelecer casos de negócios;

- Governança;

- Legal/Jurídico;

- Regulatório;

- Usando ou implementando soluções de modelos de linguagem grande;

- Teste, Avaliação, Verificação e Validação (TEVV, sigla em inglês);

- Cartões modelo e cartões de risco;

- RAG: Otimização de modelo de linguagem grande;

- Red Teaming IA.

Framework NIST para Inteligência Artificial

A NIST, Instituto Nacional de Padrões e Tecnologia dos Estados Unidos, também lançou um framework com recomendações para o gerenciamento de riscos envolvendo Inteligências Artificiais. Ele aborda:

- Principais desafios do gerenciamento de riscos de IA;

- Riscos e confiabilidades da IA;

- Eficácia do framework;

- Práticas essenciais;

- E outros pontos relevantes.

Conclusão

Grandes agências de segurança cibernética já estão se atentando para os riscos associados aos modelos LLM e às ferramentas de Inteligência Artificial.

Portanto, caso a sua organização desenvolva esse tipo de aplicação, é fundamental estar atento(a) às ameaças de segurança e às medidas essenciais, como o Pentest LLM.

Clique aqui para falar com a nossa equipe e saber mais sobre o Pentest LLM.

Quer acompanhar mais conteúdos da Vantico? Clique aqui e siga-nos no LinkedIn.